La Inteligencia Artificial aplicada al sistema judicial, es decir, el trabajo de los algoritmos que predicen las posibilidades de reincidencia de los delincuentes y sus fianzas económicas para permanecer en libertad, no es una técnica fiable, según el informe que ha publicado «Partnership on AI».

Este es un consorcio de la industria de la tecnología centrado en establecer las mejores prácticas para los sistemas de IA y en informar y educar al público sobre esta nueva técnica que invade nuestras vidas a pasos agigantados.

Los intentos de Estados Unidos de reducir la población carcelaria a través de predicciones informáticas del comportamiento de los delincuentes se basan en una comprensión errónea y podrían reforzar los prejuicios existentes, según concluyeron los expertos en inteligencia artificial que elaboraron el informe de Partnership on AI.

Como resultado, las herramientas basadas en algoritmos «no deben usarse solas para tomar decisiones sobre la detención o continuidad de la misma”.

Aunque el programa se aplica hasta el momento en algunos Estados de los Estados Unidos, las fuerzas policiales de Reino Unidos también tienen un gran interés en herramientas computarizadas de evaluación de riesgos basadas en la inteligencia artificial.

A pesar de que el objetivo final es positivo, ya que se trata de eliminar los prejuicios en las evaluaciones a la hora de estimar si un preso va o no a fugarse durante su libertad condicional a la espera de juicio, sin embargo se cuestiona si los algoritmos son el instrumento adecuado para el trabajo.

«Es un grave malentendido pensar que las herramientas son objetivas o neutrales simplemente porque están basadas en datos», señala el informe.

«Si bien las fórmulas y los modelos estadísticos proporcionan cierto grado de consistencia y replicabilidad, aún comparten o amplifican muchas debilidades de la toma de decisiones humanas».

Los algoritmos aplicados a las decisiones judiciales no están muy conseguidos, hasta ahora.

Un problema básico es la «falacia ecológica», también conocida como “falacia de ambigüedad por división”, una mala interpretación de los datos estadísticos que se produce cuando los datos recopilados sobre un grupo se aplican para que el sistema pueda predecir el comportamiento de un individuo concreto: lo que comúnmente conocemos como estereotipos y que afectan a la raza, religión, clase, etc.

El informe establece también una serie de requisitos que las jurisdicciones deben evaluar antes de adoptar una decisión mediante algoritmo, entre otros la aplicación de métodos para medir y mitigar los errores.

Sin embargo, incluso cumpliendo con todos los requisitos, los expertos siguen preguntándose si resulta aceptable tomar decisiones sobre la libertad de una persona basándose en datos sobre otros individuos.

“El uso de herramientas de evaluación de riesgos para tomar decisiones justas sobre la libertad humana requeriría resolver profundos desafíos éticos, técnicos y estadísticos, lo que incluye garantizar que las herramientas se diseñen y construyan para mitigar los errores y encontrar los protocolos adecuados”.

Las herramientas actualmente disponibles deben cumplir primero con los requisitos básicos recomendados por el informe y en caso contrario no deben utilizarse.

Los requisitos del informe “representan un estándar mínimo para los desarrolladores y formuladores de políticas que intentan alinear sus herramientas de evaluación de riesgos, y cómo se usan en la práctica, con objetivos de políticas bien fundados «.

La organización autora del estudio, Partnership of AI, está compuesto por más de 80 grupos y compañías norteamericanas, incluyendo Accenture, ACLU, Berkman Klein Center en la Universidad de Harvard, Google, IBM, Samsung, Sony, entre otras.

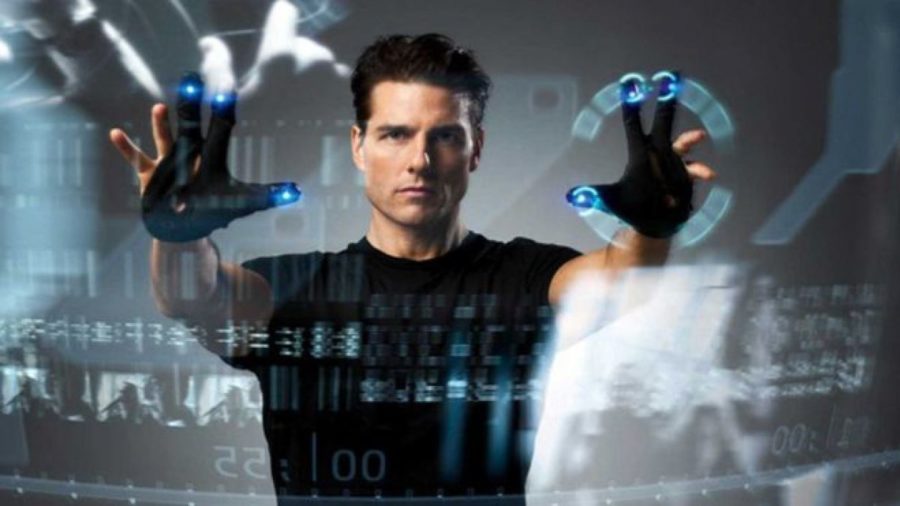

En «Minority Report», la película dirigida por Steven Spielberg y basada en un relato de ciencia ficción de Philip K. Dick, la delincuencia se elimina casi totalmente gracias a las visiones de tres mutantes que predicen los delitos que se van a cometer, lo que permite arrestar a los criminales antes de delinquir.

Pero en la realidad, que una máquina decida sobre la vida humana siempre da lugar a controversias.

Investigadores y defensores de los derechos civiles han dudado sobre su fiabilidad temiendo que sus resultados sean injustos.

En Minority Report Tom Cruise es un policía que detiene a personas que no han cometido delito alguno en base a las visiones de tres mutantes.

Hay un caso paradigmático, el de un hombre de Wisconsin, Eric L. Loomis, que fue sentenciado a seis años de prisión en parte por un informe generado por el algoritmo secreto de un software privado, que la defensa no pudo inspeccionar o cuestionar.

Se trataba del programa COMPAS, vendido por Northpointe Inc, que sentenció respecto a Loomis «un alto riesgo de violencia, un alto riesgo de reincidencia, un alto riesgo antes del juicio», según dijo el fiscal, conclusiones con las que el juez estuvo de acuerdo.

Pero no tardaron en alzarse voces disidentes, incómodas con el uso de un algoritmo secreto que había enviado un hombre a la cárcel.

Salió a la luz un informe de un equipo de investigadores liderado por Julia Dressel, estudiante de informática en el Dartmouth College, que tras analizar la validez de los resultados de COMPAS, encontró que el algoritmo que utiliza no es más fiable que cualquier humano sin preparación.

Y además había sospechas de que el sistema favorecía a los blancos frente a los negros.

Dressel se basó en la base de datos ProPublica, una colección de puntuaciones de COMPAS para 10.000 acusados en espera de juicio en el Condado de Broward, Florida, así como también sus registros de arrestos para los siguientes dos años.

La investigadora seleccionó al azar a 1.000 de los acusados y registró siete datos sobre cada uno, incluyendo su edad, sexo y número de detenciones previas.

Luego reclutó a 400 voluntarios de investigación, sin preparación previa y de diferentes edades y niveles educativos, que recibieron perfiles de 50 acusados para pronosticar si volverían a ser arrestados dentro de un periodo de dos años, el mismo estándar que utiliza COMPAS.

Los humanos acertaron casi con la misma frecuencia que el algoritmo, entre el 63% y el 67% de las veces, en comparación con el 65% de COMPAS, según la revista «Science Advances».

Resulta que los humanos puntúan tan bien como el algoritmo cuando predicen correctamente la detención de alguien. Pero cuando se equivocan, revelan un sesgo racial similar.

Tanto el hombre como la máquina supusieron incorrectamente que habría más arrestos de personas negras de lo que realmente sucedió (falsos positivos) y menos arrestos de blancos (falsos negativos).

Es difícil defenderse de estos algoritmos sin tener acceso a los mismos, ya que la compañía que comercializa COMPAS dice que su fórmula es un secreto comercial.

Este y otros productos con algoritmos similares se utilizan para establecer una fianza e incluso contribuir a las determinaciones sobre la culpabilidad o la inocencia, pero el funcionamiento interno de estas herramientas es inaccesible tanto para el acusado como para los abogados, fiscales y jueces.

Aunque Loomis impugnó su sentencia porque no se le permitió evaluar el algoritmo, la Corte Suprema del Estado falló en su contra razonando que el conocimiento de los resultados del algoritmo era un nivel suficiente de transparencia.

Pero juristas y expertos opinan que sin las garantías adecuadas, estas herramientas corren el riesgo de erosionar el Estado de Derecho y disminuir los derechos individuales.

Haciendo eco de la primera ley de la tecnología de Kranzberg, estos algoritmos no son ni buenos ni malos, pero ciertamente no son neutrales.

Los expertos alertan de que aceptar la AI en el sistema jurídico sin un plan previo de implantación y evaluación es permitir ciegamente que la tecnología avance.

Por ello, lo más conveniente sería crear una moratoria sobre el uso de la IA opaca en la evaluación de riesgos de la justicia penal, al menos hasta que haya procesos y procedimientos establecidos que permitan un examen significativo de estas herramientas y eviten que los algoritmos no controlados desvíen el sistema de justicia penal.

Comenzando por asegurar que los datos en los que se entrenan los algoritmos sean representativos de toda la población, es importante que el Gobierno establezca estándares regulatorios para garantizar la imparcialidad y la transparencia del algoritmo, mediante la publicación periódica de información que pueda ser auditada por organizaciones como los grupos de derechos civiles.

Mientras, en Europa no se ha llegado tan lejos pero un conjunto de científicos de la Universidad de Sheffield (Reino Unido) y de la Universidad de Pensilvania (Estados Unidos) ha desarrollado un sistema que prediceel resultado de decisiones judiciales con gran precisión, ya que se anticipó correctamente al 79% de los veredictos del Tribunal Europeo de Derechos Humanos (TEDH) a través deun análisis de texto utilizando un algoritmo de aprendizaje automático.

Para desarrollar este sistema, el equipo de investigadores, liderado por el doctor Aletras, se dio cuenta de que las sentencias del Tribunal Europeo de Derechos Humanos están correlacionadas con hechos no legales más que con los argumentos directamente legales.

Esto significa que son más realistas que formalistas, unos resultados que concuerdan con los de otros estudios realizados en tribunales de alto nivel, como el Tribunal Supremo de Estados Unidos.

La investigación se basó en 584 casos relacionados con los artículos 3, 6 y 8 de la Convención Europea de Derechos Humanos para aplicar su algoritmo de inteligencia artificial en busca de patrones en el texto.

Descubrieron que los factores más fiables para predecir la decisión del tribunal son el lenguaje utilizado y los temas y las circunstancias mencionadas en el caso.

Con esta información el sistema fue capaz de conseguir una precisión de acierto del 79%.

Unión Profesional presenta la revolución digital de la colegiación

24 JUL 2025Unión Profesional, la asociación que agrupa a las profesiones colegiadas ha venido trabajando ...

La herramienta de consulta judicial Horus-Visor evoluciona y adopta una nueva identidad: ATENEA IRIS

16 JUL 2025La Dirección General de Transformación Digital de la Administración de Justicia ha anunciado ...

Mediación, diálogo, consenso… los operadores de la justicia buscan soluciones ante el conflicto

02 JUL 2025El pulso entre jueces y ministerio amenaza con asfixiar a los recién constituidos tribunales de ...

Palma 29 DE MARZO 2022 El día 31 de marzo de 2022 a las 19,30 horas se llevará a cabo el acto de ...

“Ya me conocen, saben de dónde vengo. Quiero decirles que estoy aquí para ustedes”. ...

VIA ALEMANIA, 5, Edificio Juzgados

07003, PALMA DE MALLORCA, ILLES BALEARS

Tel. 0034 971 723 912 · 0034 971 723 913

© 2025 · Todos los derechos reservados a www.procuradoresdebaleares.es - Diseño Web y desarrollo Webstyle

Utilizamos cookies propias y de terceros para realizar el análisis de navegación de los usuarios y mejorar nuestros servicios. Si continuas navegando, consideramos que acepta su uso. Puedes obtener más información y configurar tus preferencias aquí. Configurar Cookies - Política de privacidad.