La Intel·ligència Artificial aplicada al sistema judicial, és a dir, el treball dels algorismes que prediuen les possibilitats de reincidència dels delinqüents i les seves fiances econòmiques per a romandre en llibertat, no és una tècnica fiable, segons l'informe que ha publicat «Partnership on AI».

Aquest és un consorci de la indústria de la tecnologia centrat en establir les millors pràctiques per als sistemes de IA i a informar i educar al públic sobre aquesta nova tècnica que envaeix les nostres vides amb passes de gegant.

Els intents dels Estats Units de reduir la població carcerària a través de prediccions informàtiques del comportament dels delinqüents es basen en una comprensió errònia i podrien reforçar els prejudicis existents, segons van concloure els experts en intel·ligència artificial que van elaborar l'informe de Partenariat on AI.

Com a resultat, les eines basades en algorismes «no han d'usar-se soles per a prendre decisions sobre la detenció o continuïtat d'aquesta”.

Encara que el programa s'aplica fins al moment en alguns Estats dels Estats Units, les forces policials de Regne Units també tenen un gran interès en eines informatitzades d'avaluació de riscos basades en la intel·ligència artificial.

A pesar que l'objectiu final és positiu, ja que es tracta d'eliminar els prejudicis en les avaluacions a l'hora d'estimar si un pres va o no a escapolir-se durant la seva llibertat condicional a l'espera de judici, no obstant això es qüestiona si els algorismes són l'instrument adequat per al treball.

«És un greu malentès pensar que les eines són objectives o neutrals simplement perquè estan basades en dades», assenyala l'informe.

«Si bé les fórmules i els models estadístics proporcionen cert grau de consistència i replicabilidad, encara comparteixen o amplifiquen moltes febleses de la presa de decisions humanes».

Els algorismes aplicats a les decisions judicials no estan molt aconseguits, fins ara.

LA “FAL·LÀCIA ECOLÒGICA”

Un problema bàsic és la «fal·làcia ecològica», també coneguda com a “fal·làcia d'ambigüitat per divisió”, una mala interpretació de les dades estadístiques que es produeix quan les dades recopilades sobre un grup s'apliquen perquè el sistema pugui predir el comportament d'un individu concret: el que comunament coneixem com a estereotips i que afecten la raça, religió, classe, etc.

L'informe estableix també una sèrie de requisits que les jurisdiccions han d'avaluar abans d'adoptar una decisió mitjançant algorisme, entre altres l'aplicació de mètodes per a mesurar i mitigar els errors.

No obstant això, fins i tot complint amb tots els requisits, els experts continuen preguntant-se si resulta acceptable prendre decisions sobre la llibertat d'una persona basant-se en dades sobre altres individus.

“L'ús d'eines d'avaluació de riscos per a prendre decisions justes sobre la llibertat humana requeriria resoldre profunds desafiaments ètics, tècnics i estadístics, la qual cosa inclou garantir que les eines es dissenyin i construeixin per a mitigar els errors i trobar els protocols adequats”.

Les eines actualment disponibles han de complir primer amb els requisits bàsics recomanats per l'informe i en cas contrari no han d'utilitzar-se.

Els requisits de l'informe “representen un estàndard mínim per als desenvolupadors i formuladores de polítiques que intenten alinear les seves eines d'avaluació de riscos, i com s'usen en la pràctica, amb objectius de polítiques ben fundats «.

L'organització autora de l'estudi, Partenariat of AI, està compost per més de 80 grups i companyies nord-americanes, incloent Accenture, ACLU, Berkman Klein Center en la Universitat d'Harvard, Google, IBM, Samsung, Sony, entre altres.

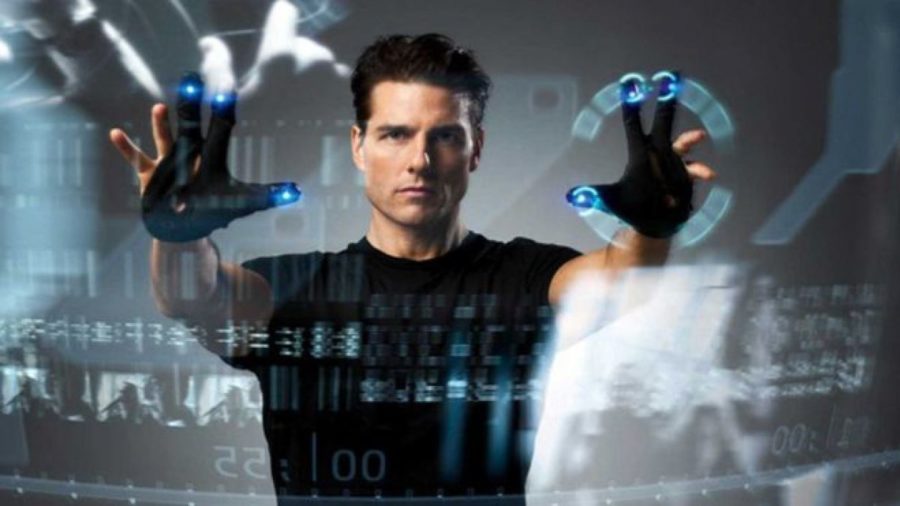

MINORITY REPORT FET REALITAT

En «Minority Report», la pel·lícula dirigida per Steven Spielberg i basada en un relat de ciència-ficció de Philip K. Dick, la delinqüència s'elimina gairebé totalment gràcies a les visions de tres mutants que prediuen els delictes que es cometran, la qual cosa permet arrestar als criminals abans de delinquir.

Però en la realitat, que una màquina decideixi sobre la vida humana sempre dóna lloc a controvèrsies.

Investigadors i defensors dels drets civils han dubtat sobre la seva fiabilitat tement que els seus resultats siguin injustos.

En Minority Report Tom Cruise és un policia que deté a persones que no han comès cap delicte sobre la base de les visions de tres mutants.

Hi ha un cas paradigmàtic, el d'un home de Wisconsin, Eric L. Loomis, que va ser sentenciat a sis anys de presó en part per un informe generat per l'algorisme secret d'un programari privat, que la defensa no va poder inspeccionar o qüestionar.

Es tractava del programa COMPAS, venut per Northpointe Inc, que va sentenciar respecte a Loomis «un alt risc de violència, un alt risc de reincidència, un alt risc abans del judici», segons va dir el fiscal, conclusions amb les quals el jutge va estar d'acord.

Però no van trigar a alçar-se veus dissidents, incòmodes amb l'ús d'un algorisme secret que havia enviat un home a la presó.

Va sortir a la llum un informe d'un equip d'investigadors liderat per Julia Dressel, estudiant d'informàtica en el Dartmouth College, que després d'analitzar la validesa dels resultats de COMPAS, va trobar que l'algorisme que utilitza no és més fiable que qualsevol humà sense preparació.

I a més hi havia sospites que el sistema afavoria als blancs enfront dels negres.

Dressel es va basar en la base de dades ProPublica, una col·lecció de puntuacions de COMPAS per a 10.000 acusats en espera de judici en el Comtat de Broward, Florida, així com també els seus registres d'arrestos per als següents dos anys.

La investigadora va seleccionar a l'atzar a 1.000 dels acusats i va registrar set dades sobre cadascun, incloent la seva edat, sexe i nombre de detencions prèvies.

Després va reclutar a 400 voluntaris de recerca, sense preparació prèvia i de diferents edats i nivells educatius, que van rebre perfils de 50 acusats per a pronosticar si tornarien a ser arrestats dins d'un període de dos anys, el mateix estàndard que utilitza COMPAS.

Els humans van encertar gairebé amb la mateixa freqüència que l'algorisme, entre el 63% i el 67% de les vegades, en comparació amb el 65% de COMPAS, segons la revista «Science Advances».

Resulta que els humans puntuen tan bé com l'algorisme quan prediuen correctament la detenció d'algú. Però quan s'equivoquen, revelen un biaix racial similar.

Tant l'home com la màquina van suposar incorrectament que hi hauria més arrestos de persones negres del que realment va succeir (falsos positius) i menys arrestos de blancs (falsos negatius).

És difícil defensar-se d'aquests algorismes sense tenir accés a aquests, ja que la companyia que comercialitza COMPAS diu que la seva fórmula és un secret comercial.

Aquest i altres productes amb algorismes similars s'utilitzen per a establir una fiança i fins i tot contribuir a les determinacions sobre la culpabilitat o la innocència, però el funcionament intern d'aquestes eines és inaccessible tant per a l'acusat com per als advocats, fiscals i jutges.

Encara que Loomis va impugnar la seva sentència perquè no se li va permetre avaluar l'algorisme, la Cort Suprema de l'Estat va fallar en contra seva raonant que el coneixement dels resultats de l'algorisme era un nivell suficient de transparència.

Però juristes i experts opinen que sense les garanties adequades, aquestes eines corren el risc d'erosionar l'Estat de Dret i disminuir els drets individuals.

Fent ressò de la primera llei de la tecnologia de Kranzberg, aquests algorismes no són ni bons ni dolents, però certament no són neutrals.

Els experts alerten que acceptar l'AI en el sistema jurídic sense un pla previ d'implantació i avaluació és permetre cegament que la tecnologia avanci.

Per això, el més convenient seria crear una moratòria sobre l'ús de la IA opaca en l'avaluació de riscos de la justícia penal, almenys fins que hi hagi processos i procediments establerts que permetin un examen significatiu d'aquestes eines i evitin que els algorismes no controlats desviïn el sistema de justícia penal.

Començant per assegurar que les dades en els quals s'entrenen els algorismes siguin representatius de tota la població, és important que el Govern estableixi estàndards reguladors per a garantir la imparcialitat i la transparència de l'algorisme, mitjançant la publicació periòdica d'informació que pugui ser auditada per organitzacions com els grups de drets civils.

LES PREDICCIONS EUROPEES

Mentrestant, a Europa no s'ha arribat tan lluny però un conjunt de científics de la Universitat de Sheffield (Regne Unit) i de la Universitat de Pennsilvània (els Estats Units) ha desenvolupat un sistema que prediceel resultat de decisions judicials amb gran precisió, ja que es va anticipar correctament al 79% dels veredictes del Tribunal Europeu de Drets Humans (TEDH) a través deun anàlisis de text utilitzant un algorisme d'aprenentatge automàtic.

Per a desenvolupar aquest sistema, l'equip d'investigadors, liderat pel doctor Aletras, es va adonar que les sentències del Tribunal Europeu de Drets Humans estan correlacionades amb fets no legals més que amb els arguments directament legals.

Això significa que són més realistes que formalistes, uns resultats que concorden amb els d'altres estudis realitzats en tribunals d'alt nivell, com el Tribunal Suprem dels Estats Units.

La recerca es va basar en 584 casos relacionats amb els articles 3, 6 i 8 de la Convenció Europea de Drets Humans per a aplicar el seu algorisme d'intel·ligència artificial a la recerca de patrons en el text.

Van descobrir que els factors més fiables per a predir la decisió del tribunal són el llenguatge utilitzat i els temes i les circumstàncies esmentades en el cas.

Amb aquesta informació el sistema va ser capaç d'aconseguir una precisió d'encert del 79%.

Ciutadans i empreses ja poden fer tots els pagaments a l'Administració de Justícia amb targeta

13 MAI 2025Ciutadans i empreses ja poden fer tots els pagaments a l'Administració de Justícia amb targeta de ...

La majoria d'advocats i procuradors rebutja la proposta del PSOE per al seu pas al RETA

06 MAI 2025Milers d'advocats i procuradors mutualistes de tota Espanya porten anys esperant una solució per part de ...

El Ministeri de Justícia publica el justificant d'anomalies de Lexnet en la prestació del servei el 28 i 29 d'abril

02 MAI 2025El Ministeri de Presidència, Justícia i Relacions amb les Corts ha publicat el justificant d'anomalies ...

El director general de Transformació Digital de l'Administració de Justícia, Aitor Cubo, ...

Palma 29 DE MARÇ 2022El dia 31 de març de 2022 a les 19,30 hores es durà a terme ...

“Ja em coneixen, saben d'on vinc. Vull dir-los que sóc aquí per a vostès”. Amb ...

Palma 23 D’ABRIL 2019 La seu del Tribunal Superior de Justícia de les Illes Balears ...

VIA ALEMANIA, 5, Edificio Juzgados

07003, PALMA DE MALLORCA, ILLES BALEARS

Tel. 0034 971 723 912 · 0034 971 723 913

© 2025 · Tots els drets reservats a www.procuradoresdebaleares.es - Diseño Web y desarrollo Webstyle

Utilitzem cookies pròpies i de tercers per realitzar l'anàlisi de navegació dels usuaris i millorar els nostres serveis. Si continues navegant, considerem que accepta el seu ús. Pots obtenir més informació i configurar les teves preferències aquí. Configurar Cookies - Política de privacitat.